AIファクトチェック最前線!Perplexityで広がる信頼性アップ術と実践ポイント

目次

企業のコンテンツ発信において、情報の「信頼性」は、読者の信頼を勝ち取るための生命線です。

しかし、インターネット上に情報があふれる現代、そのなかには誤情報やフェイクニュースが紛れ込んでおり、正確な情報を見極める力、すなわち「ファクトチェック」の重要性がこれまでになく高まっています。

事実、世界経済フォーラム(WEF)が2024年1月と2025年1月に2年連続で発表した「グローバルリスク報告書」において、「誤情報と偽情報(Misinformation and disinformation)」は「今後2年間(短期)」で世界が直面する最大のリスクとして第1位に挙げられました。

これは、巧妙化する偽情報が社会全体に不信感を生むなかで、企業もひとたび誤った情報を発信すれば、築き上げたブランドイメージや顧客の信頼を瞬時に失いかねない、という厳しい現実を示しています。

この記事では、AI検索エンジン「Perplexity(パープレキシティ)」を活用し、コンテンツの信頼性を飛躍的に高めるためのファクトチェック術を、具体的な手順や注意点と共に詳しく解説します。

- AI検索エンジン「Perplexity」がファクトチェックにおいて非常に有用であること

- ファクトチェックの重要性とPerplexityの活用方法

- AI利用時の注意点と人間の最終判断の重要性

ファクトチェックとは?

まず、ファクトチェックがなぜ重要なのか、その定義と基本的なプロセスを解説します。

ファクトチェックの定義

「ファクトチェック」とは、情報や発言の事実性を検証し、真偽を確かめる作業のことです。

具体的には、データの正確性、統計の信頼性、引用の正当性、情報源の信頼度などを多角的に調査し、その情報が事実に基づいているかを判断します。

近年、インターネットやSNSの普及により、情報の広がる速度は飛躍的に上がりました。

その一方で、誤情報やフェイクニュースも瞬く間に社会に広がり、判断ミスや混乱を引き起こすことが増えています。

実際、世界経済フォーラム(WEF)が発表したGlobal Risks Report 2025では、「誤情報・偽情報(misinformation and disinformation)」が、今後2年間における世界規模のリスクとして第1位に位置付けられています。

この調査は、2024年9〜10月に900名以上のグローバルリスク専門家や政策担当者、業界リーダーを対象に実施されました。

また、ロイター研究所による「Digital News Report 2025」の調査では、48市場の平均で58%の人が「オンラインで情報の真偽を見分けられるか不安」と回答しており、情報全体への不信感が高まっています。

さらに、日本国内でも、総務省「ICTリテラシー実態調査 2025」の結果から、偽・誤情報に接触した人のうち47.7%が「正しい情報だと思った」と回答し、25.5%が実際に他者へ拡散したという調査結果が出ています。

こうした数字は、誤情報が社会に定着する過程のリアルな姿を示しています。

これらの統計から、ファクトチェックは単なる精査作業ではなく、社会の情報環境を根本から守る重要な役割を担っているといえます。

特に、情報発信の信頼性が問われる現代では、迅速かつ透明性のある確認手段が不可欠です。

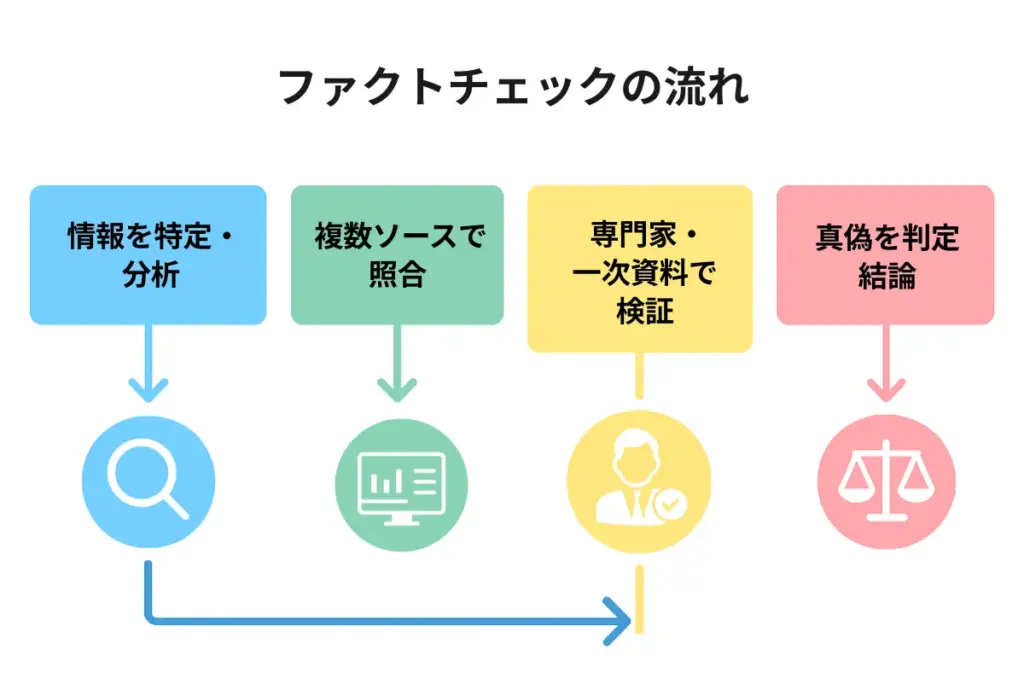

ファクトチェックの基本プロセス

一般的なファクトチェックは、主に以下の4つのステップで進められます。

ステップ1:情報の特定と分析

まず、確認したい情報(記事や発言など)が、何を主張しているのかを正確に理解する。

ステップ2:関連データの収集と比較

次に、公的機関の統計や複数の報道機関のニュースなど、信頼できる情報源を複数探し、確認したい情報と内容を比べ合わせる。

ステップ3:一次情報による裏付け

可能であれば、専門家の論文や公式発表といった「元の情報源(一次情報)」まで遡り、主張が本当に正しいかを多角的に確認する。

ステップ4:結論の判定

集めた証拠を基に、その情報が「正確」「一部不正確」「完全な誤り」などを総合的に判断する。

しかし、このプロセスには時間と手間がかかるという大きな課題がありました。そこで注目されているのが、特にステップ2と3を劇的に効率化してくれるPerplexityのようなAIツールです。

AIファクトチェック最前線! Perplexityの実力と特徴

多くの専門家や企業が注目するAI検索エンジン「Perplexity」。ここでは、その運営企業や成長の背景、そして従来の検索エンジンと一線を画す理由を詳しく解説します。

Perplexityとは? 運営企業と注目される理由

従来の検索エンジンとは一線を画すAI検索ツールとして、いま多くの専門家や情報リテラシーの高いユーザーから注目を集めているのが「Perplexity(パープレキシティ)」です。

このサービスを運営するPerplexity AI社(本社:米国カリフォルニア州サンフランシスコ)は、2022年設立のAIスタートアップです。

創業メンバーには、OpenAIやGoogle、Metaなどの出身者を含む、世界的なAI研究者・技術者らが名を連ねています。

初期投資家にはエヌビディアやAmazon創業者のジェフ・ベゾスらが名を連ね、2024年にはソフトバンクグループなどからも大規模な出資を受けるなど、急速に開発と普及が進んでいます。

Perplexityは「AIの対話能力」と「Web検索の即時性」を組み合わせた新しいタイプの検索エンジンで、利用者が投げかけた疑問や調査テーマに対し、最新のWeb情報を検索し、出典を明示したうえで要点をわかりやすく提示するのが最大の特徴です。

この革新性によって、「信頼できる情報を、すぐに・正しく見つけたい」という現代の課題に応えるツールとして世界的に注目されています。

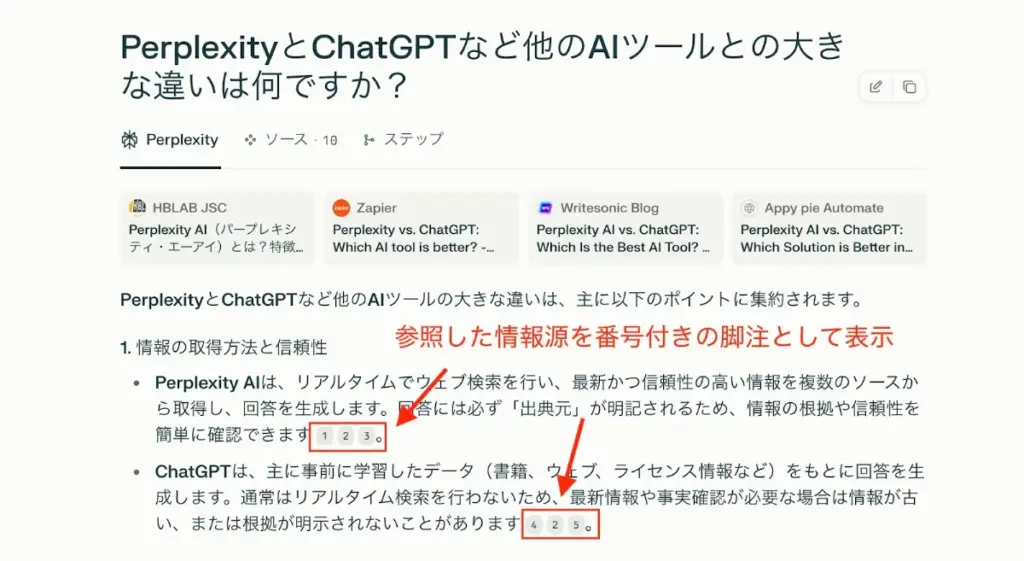

Perplexityの基本機能とほかのAIツールとの違い

Perplexityは、AIの対話能力とWeb検索機能を融合させた、新しいタイプのAI検索ツールです。

一般的な対話型AI(ChatGPTなど)は「過去に学習したデータ」を基に回答しますが、Perplexityは常に最新のWeb情報を検索し、情報源(出典)を明記して回答する点が最大の特徴です。

こうした仕組みによって、情報の「鮮度」と「透明性」が格段に向上しました。

近年はPerplexity以外にもリアルタイム検索や出典表示に対応したAIツールが次々と登場しており、主なツールの特徴を下表にまとめています。

| ツール名 | リアルタイム 検索 | 出典表示 | 主な特徴 |

|---|---|---|---|

| Perplexity AI | ◎ | ◎ | Web検索結果を即時反映。Academicフィルターで学術・学問的な情報源の絞り込みも可質問ごとに出典リンクを明記。 |

| Copilot(旧Bing Chat) | ◎ | ◎ | Bing検索と連携。回答内に出典リンクを表示。 |

| Google Gemini(旧Bard) | ◎ | ◯ | Google検索結果を即時反映。出典リンクは一部回答のみ。 |

| ChatGPT(Bing連携時) | △ | △ | 有料プラン(Plus/Enterprise)で「Browse with Bing」利用により即時反映可。検索を経由した場合のみ出典リンクを明記。 |

出典表示の正確さではCopilotも非常に優秀です。両者の大きな違いは、その得意領域にあります。

- Perplexity は…… 最新情報や学術論文の調査など、正確な情報収集(リサーチ)に特化した「検索の専門家」です。

- Copilot は…… 検索に加え、メール作成やOffice資料の作成などもこなす、万能型の「AIアシスタント」です。

そのため、情報の根拠を深掘りする「ファクトチェック」という目的においては、リサーチに最適化されたUIと機能を持つ Perplexityが特に優れた選択肢といえます。

ファクトチェックで役立つPerplexityの主要機能

Perplexityには、情報の信頼性検証を強力にサポートする機能が備わっています。

リアルタイム検索機能

PerplexityはWeb上の最新情報をリアルタイムで検索・要約します。

ニュースや経済動向、医療研究など「今まさに動いている」情報にも即座にアクセスできるため、速報性が重要なファクトチェックに圧倒的な強みを発揮します。

「2025年現在の円相場は?」「最新の医学論文で○○は証明されているか?」といった、日々変化するトピックにも正確に対応します。

出典表示機能

Perplexityでは、AIが生成した回答ごとに番号付きの出典URLが必ず表示されます。

どの情報源を根拠にしているかが明確にわかるため、情報の裏付けや再検証が簡単にできるのが大きな特徴です。

表示された検索結果で「このデータはどこから?」と気になった情報は、ワンクリックで公式文書やニュースソースを直接確認することが可能です。

Deep Research機能

「Deep Research」では、複数の関連情報を横断的に自動検索し、詳細な調査レポートを短時間で作成します。複数ソースの比較や、情報の偏り・バイアスを減らしたいときに特に有効です。

例えば、「このテーマについての専門家の意見と統計データをまとめて知りたい」といった、多角的な検証が必要な場面で役立ちます

画像生成・画像分析機能(Proプランなど)

一部の有料プランでは、AIによるグラフや図表の自動生成、画像データの要約なども可能。

テキストとビジュアル両面から情報の信頼性を確認したい場合に有用です。

履歴・フォルダ管理機能

過去の調査履歴やテーマごとにフォルダ分けして保存・再利用できるため、継続的なリサーチや「後から見直し・再検証したい」ときにも便利です。

Perplexityがファクトチェックで支持される理由

こうした主要機能を組み合わせることで、Perplexityは従来型ツールにおける「AIの回答がブラックボックス化する」という課題を大きく改善しています。

Perplexityの機能

- 出典の透明性:根拠・出所が明示され、ユーザー自身で真偽確認・再検証ができる

- リアルタイム性:最新情報にアクセスでき、「古い知識・誤情報」に頼らない

- 多角的な検証:Deep Researchなどで、複数ソース照合やバイアス回避が容易

このため、正確性が厳しく問われるメディア、金融、医療、研究機関などの現場で、高く評価されています。

実際の活用方法と成功事例

では、実際にPerplexityをどのように活用すればよいのでしょうか。具体的な手順と、企業や個人での導入事例を紹介します。

実践的なファクトチェック3ステップ

Perplexityを活用したファクトチェックは、次の3ステップで進めると実践的です。

ステップ1:記事全体のファクトチェック

記事や資料の全文をPerplexityに入力し、「この記事の内容は事実に基づいていますか? 不正確な点や要確認の点を指摘してください」と質問します。

まず全体像を把握し、AIがどの部分に疑義を呈するかを確認します。

ステップ2:疑問点をピンポイントで深掘り

ステップ1で洗い出された箇所や、特に気になる部分について、「〇〇という主張の根拠となる一次情報を教えてください」のように、具体的な質問を重ねて深掘りします。

ステップ3:AIの出典を人間が二次確認

AIが示した出典URLを必ず自分で確認し、内容を精読します。公的機関のデータや信頼できる報道機関であっても鵜呑みにせず、最終的な判断は人間が行うことが、ファクトチェックの鉄則です。

企業・組織での導入事例

Perplexityは、今やテック系大手企業からメディア、そして実務現場まで幅広く導入が進んでいます。

それらの現場で見られる特徴は「単なるAI活用の流行」ではなく、本気で「効率」と「信頼性」の両立を求める現場で、日々の業務変革を後押ししている点です。

ソフトバンクグループの全社的な活用

2024年、ソフトバンクグループはPerplexity AIと戦略的なパートナーシップを結び、グループ全体でAI検索エンジンの活用を一気に拡大しました。

通信・ITインフラを担う同社が「次世代AIによる情報革命」の中核に据えたのが、このPerplexityです。

専務執行役員の寺尾洋幸氏は、Perplexity AIとの提携発表会見でこれまでソフトバンクはインターネット革命、ブロードバンド革命、モバイル革命という3つの大きな波を乗り越えてきており、次は、AI革命の時代であると強調し、AIと共存する社会における「心地よいユーザー体験」の重要性を語っています。

その象徴として、ソフトバンク・ワイモバイル・LINEMOの各ユーザーに「Perplexity Pro」を1年間無料で開放しました(2025年8月時点、1年間無料キャンペーンは終了)。

さらに2025年3月からは企業向けの「Perplexity Enterprise Pro」がスタートし、アクセス管理・セキュリティ・履歴保存など、業務利用に適したプロフェッショナルな機能を備えています。

ソフトバンクグループでは、Perplexityを活用することで、膨大な情報のなかから必要なデータや最新の業界動向を効率的に把握できる点が、大きな魅力としています。

さらに、社内文書やFAQ作成の自動化による業務効率の向上も見込んでいます。。

また、社内外向けの説明資料や報告書においては、根拠データの確認や情報の正確性を担保する目的でも、AIによる出典付き検索の導入が業務負担の軽減につながると見ています。

このように、「情報収集の効率化」や「根拠ある資料作成」「意思決定のスピードアップ」などが主な導入理由となっており、今後はAIと人が協力し合うことで現場全体の生産性がさらに高まることが期待されています。

ITメディア、研究機関、教育現場での定着

ITmedia(アイティメディア)は、2025年にPerplexityのパブリッシャープログラムに参画し、自社での活用を推進することを発表しています。

加えて、大学や研究機関、教育現場などでも、参考文献や根拠資料の検索、論文作成の補助といった目的で、Perplexityの導入事例が広がりつつあります。

こうした分野では、「調査作業の効率化」や「正確な出典明示による説明責任の強化」といった効果が実感されているのが特徴です。

なお、自治体の広報や政策現場も、今後の導入拡大が期待される分野の一つといえるでしょう。

個人利用者による実践事例

一方、個人レベルでもPerplexityを活用したファクトチェックが日常の一部になりつつあります。

例えば、Webメディア編集者やライターの間では、記事の下書きをPerplexityに通して「この主張は正確か?」とAIに確認するスタイルが広がっています。

AIが提示する出典リンクをもとに、必要に応じて一次情報を直接確認することで、根拠のある記事づくりがよりスムーズになりました。

実際、「作業効率が上がった」「根拠確認の手間が減った」という声も多く聞かれます。

また、さまざまなビジネスの現場でも、メールや企画書のファクトチェック、資料の出典付け、誤情報の早期発見など、幅広い用途でPerplexityが役立っています。

最近では、Perplexityに加えてCopilotやGeminiなど複数のAIを目的別に使い分けるケースも一般的になりました。

異なるAIの検索結果を突き合わせ、一致した内容は「信頼度が高い」と判断するといった、「クロスチェック」を取り入れるユーザーも増えています。

事実、筆者自身(編集者)も日々の原稿チェックやリライト作業にPerplexityを活用しています。

特に「出典が不明瞭なデータ」や「専門的な統計」の裏付け確認は、従来よりも確実かつ短時間で行えるようになりました。

AIが自動で根拠となる情報源を表示してくれることで、編集部内やクライアントへの説明責任もより果たしやすくなっています。

このように、AIと人の「ダブルチェック」を日常的に取り入れることで、個人でも情報の信頼性や業務の正確さを高めることが可能になっています。

導入がもたらす「現場の変化」

Perplexityの導入は、企業・組織の業務プロセスを変えるだけでなく、個人の情報発信や判断の在り方そのものも進化させています。

「AIが探し、人が判断する」このハイブリッドなリサーチスタイルが、信頼できる情報社会の基盤となりつつあるのです。

Perplexity利用時の注意点

どんなに便利なAIツールであっても、完璧に正しい答えが返ってくるとは限りません。Perplexityを活用する際は、その利便性と共にリスクも理解し、正しい使い方を心がけることが重要です。

以下では、利用時に特に注意したいポイントと、リスクを最小限に抑える方法を具体的に解説します。

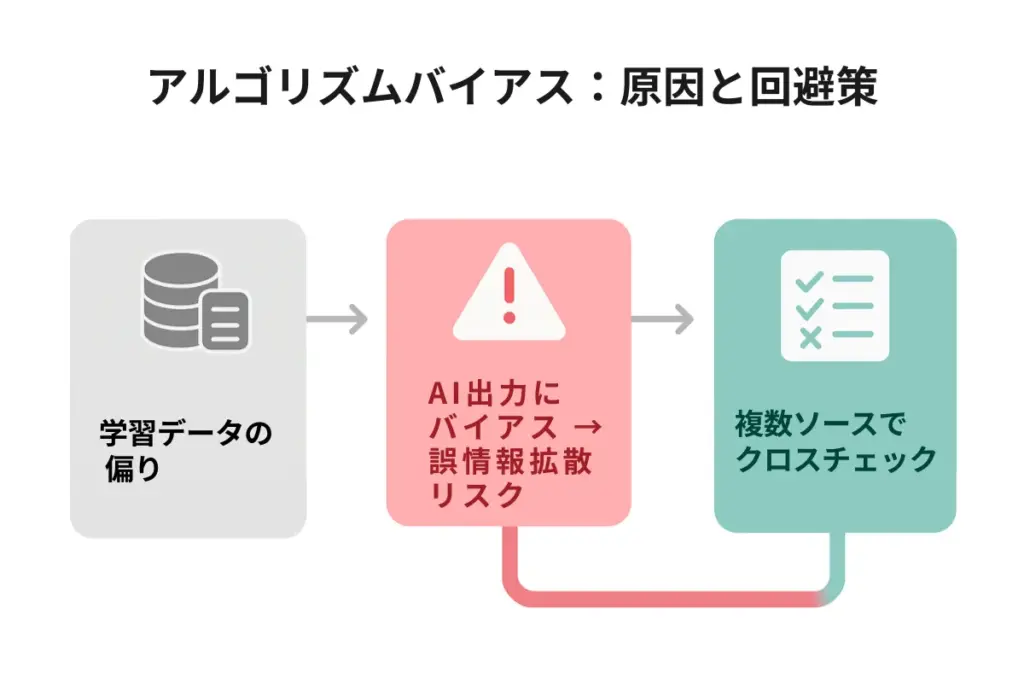

AIの「バイアス(偏り)」が情報の正確さに与える影響

AIは大量のデータから物事を学習しますが、その「教科書」となるデータ自体に偏りがあると、AIが生み出す答えも意図せず偏ってしまうことがあります。この現象を「AIのバイアス」と呼びます。

こうしたバイアスが生じる主な原因は、学習データが特定の価値観や情報に偏っている点にあるといえるでしょう。

AIのバイアスをイメージしやすくするために、「非常に博識だけれど、特定の分野ではどうしても自身の意見や経験に引っ張られてしまう専門家」にアドバイスを求める場面を想像してみてください。

この専門家は多くの知識や実績を持っていますが、もしあるテーマに限っては「自分の経験した事例」や「特定の立場の情報」ばかりを重視して話してしまうとしたら、その助言も自然と偏った内容になるでしょう。

AIも同様に、学習データや参考情報が一部に偏っている場合、どれほど高性能であっても、そのバイアスを完全に排除できるわけではありません。

そのため、AIも学習するデータが偏ると、知識や考え方に偏りが生まれてしまうのです。

この結果、次のような問題が起こり得ます。

例えば、特定の政治思想を持つニュース記事ばかりをAIに学習させると、そのバイアスがAIの判断に影響し、特定の思想が「事実」であるかのように回答を生成してしまいます。

また、医療分野で男性の臨床データに偏った学習が行われれば、女性特有の症状や治療法に関する情報が軽視されてしまう、といった事態も起こりかねません。

このように、AIがバイアスのかかった情報源だけを参照していると、本来注目すべき事実や視点が見落とされ、結果として利用者自身が誤った結論にたどり着いてしまう恐れがあります。

こうしたリスクを避けるためには、AIが提示する情報の出典や内容を必ず自分の目で確認することが重要です。

複数の信頼できる情報源をクロスチェックし「AIの答え=絶対」と決めつけず、人間の判断を組み合わせることで、より正確なファクトチェックが実現します。

ハルシネーション(幻覚)と誤答率 ―― 数字で見るリスク

AIは時に、事実に基づかない情報や、存在しない論文・データをもっともらしく生成してしまうことがあります。これを「ハルシネーション(幻覚)」と呼びます。

特にファクトチェックでは、AIの誤答率や信頼度を数値で把握しておくことが大切です。

| 指標 | 試験・調査概要 | 主な結果 |

|---|---|---|

| ハルシネーション率(要約タスク) | HHEM(Vectara)を用いたStanford HAI「AI Index 2025」 | 上位モデルの誤生成率は1.3〜2.9%。GPT-4oは1.5% |

| 法律分野での誤答率 | Stanford HAI「AI on Trial」研究(200件超の法律クエリ) | 汎用チャットボットの誤答率 58〜82% |

| ニュース検索の誤答率 | Tow Center for Digital Journalism(1600件のニュース引用実験) | Perplexityは 37%が不正確(8ツール中最も低いが誤答は依然多い) |

このデータからわかること

- 用途や分野によってAIの誤答・ハルシネーション率は大きく異なる。

ニュース要約など単純タスクでは1〜3%台とかなり低い一方で、専門領域(法律など複雑な分野)では誤答率58〜82%と高くなるケースが目立つ。 - ニュース検索タスクでは、Perplexityでも約4割弱(37%)が不正確だった。

Perplexityは、ほかのAIよりは精度が高いものの、「出典付きでも誤りが混じる」リスクは常にある。

AIやPerplexityの回答は「分野や質問内容によって精度が大きく変動する」ため、 どんなときも「出典の確認」や「複数ソースでの裏付け」が不可欠です。

検索元データが誤っていればAIも誤る

AIはどれほど慎重に回答を作成しても、参照したWebサイトや論文そのものが誤っていれば、誤情報をそのまま再生産することになります。

例えば、あるニュースサイトが、まだ裏付けの取れていない速報を「新事実」として報じたとします。これをもとにAIが要約や解説を作ると、そのまま「公式発表済み」といった「誤った情報」を信じて伝えてしまうのです。

また、とある個人ブログが「〇〇サプリでがんが治る」と根拠なく書いていた場合でも、AIがそのブログ記事を信頼できる情報源と認識してしまえば、やはり誤った内容を答えてしまいます。

このように、AIの答えは検索元の情報に大きく左右されるということを、日々意識しておく必要があります。

どんなに便利なAIでも、出典リンクや元記事を自分で開いて「本当に正しい内容か?」と確認する「ひと手間」を忘れずに、これこそが、確実なファクトチェックの基本です。

Perplexityで実際に遭遇したハルシネーション

筆者自身もPerplexityを日常的に使っていますが、何度か「これは注意が必要だ」と感じるハルシネーション(AIの誤生成)に遭遇した経験があります。

例えば、自治体の上下水道料金についてリサーチしていたときのことです。「2025年度の最新料金」を調べていたはずが、AIが出典として提示したのは、数年前に更新された古い料金表でした。

AIはページのどこが最新か、年度の切り替わりを正確に認識できていなかったようです。そのため、過去の料金が「現在の情報」として表示されていたのです。

また、企業や店舗のキャンペーン情報を調べた際にも、すでに何年も前に終了したキャンペーンを「実施中」と紹介されてしまったことがあります。

どうやら、古い情報がWeb上に残っているだけなのに、AIはそれを最新のものと判断してしまったようです。

さらに、出典リンクの中身が実際にはまったく違う内容だったケースもありました。

ある企業の社会貢献活動(CSR活動)について調べていたとき、「2024年に始まった新プロジェクトについて教えてほしい」とAIに質問したところ、一見関連しそうなURLが提示されました。

しかし、実際にリンクを開いてみると、まったく関係のない数年前のニュース記事が掲載されていたのです。

こうした体験から、AIが示す「最新情報」や「出典リンク」をそのまま信用せず、自分で一次情報や日付、記事内容を必ず確認する習慣の重要性を実感しています。

特に、公的データや公式発表など「信頼できる原典」にさかのぼるクセをつけておくと、誤情報に惑わされるリスクを大きく減らすことができます。

Perplexityでファクトチェックの未来を切り拓く

今後さらに情報があふれる時代を迎え、誤情報やフェイクニュースに惑わされない力がますます求められます。

PerplexityのようなAI検索ツールは、情報収集や事実確認を格段に効率化し、誤情報の拡散防止にも大きく貢献する頼もしい存在です。

ただし、AIの答えはあくまで「スタート地点」。最終的な判断や裏付けは、私たち自身の目と知識でしっかり行うことが、信頼される情報発信の基本となります。

「出典の確認」や「複数ソースのクロスチェック」といった小さな工夫が、AI活用の価値を大きく引き上げるコツです。

これからの時代、AIを正しく使いこなすことが、よりよい情報社会を築く土台となるでしょう。

AIリテラシーや情報発信の精度をさらに高めたいと感じた際は、「情報の信頼性向上」や「AI活用のご相談」「原稿や記事の校正・ファクトチェック」など、お気軽にHALCYAN(ハルシアン)までご相談ください。

FAQ|よくある質問と回答

ここでは、読者が「Perplexityを活用したファクトチェック」に関してよく抱く疑問や、実際の利用シーンに即した質問を取り上げ、具体的なアドバイスを提供します。

Q:PerplexityでのファクトチェックはほかのAI検索と比べて何が優れていますか?

A:Perplexityは出典表示が標準のため、信頼性や透明性の高さが優れています。

PerplexityはほかのAI検索ツールと比べて、出典表示の信頼性と透明性が非常に高い点が大きな強みです。

リアルタイムの情報検索に加えて、AIが参照した情報源を必ず明記しているため、ユーザー自身が「どこから得た情報か」を直接確認できるからです。

例えば、学術論文・公的機関・ニュースなど多様な一次情報への直接リンクが標準搭載されており、検索のたび情報が最新化される仕組みになっています。

そのため、AI検索初心者でも安心してファクトチェックに活用できるのがPerplexityの大きなポイントです。

Q:Perplexityの答えはどれくらい信頼できますか?

A:Perplexityの答えは分野によって信頼度が大きく異なります。

これは、AIの精度が質問内容や評価基準によって変動するためです。

実際にAIによる回答の精度は、ニュース分野では約37%以上が誤答、要約タスクでは1〜3%の誤生成という結果が報告されています。

そのため、どのAIツールでも「必ず出典を自分で開き、一次情報や公式資料を確認する」ことが推奨されます。

Q:Perplexityの「Deep Research」機能の活用法は?

A:Perplexityの「Deep Research」機能は、短時間で多角的かつ詳細な調査レポートを自動でまとめることができます。

数十回分の自動検索を一度に実行し、複数の情報源を横断して集約できるため、従来の検索よりも圧倒的に多くの視点と情報を得ることができるからです。

例えば、まとめられたレポートには出典一覧が明記され、一次情報まで簡単にさかのぼることができます。そのため、調査や資料作成の効率が大きく向上します。

複雑なテーマや多面的な検証が必要な場面で、情報の正確性を担保しながら効率よくリサーチしたいときに、特におすすめの機能です。

Q:AI検索によるバイアスや誤情報への対策は?

A:AI検索の答えをそのまま鵜呑みにせず、必ず情報源の多様性と専門性を意識して確認することが大切です。

AIは学習データの偏りや一部メディアへの依存など、もともとバイアスを持つ場合があり、誤情報や一面的な意見をそのまま出力してしまうリスクがあるためです。

例えば、AIが参照したニュースが特定の立場に偏っていると、そのバイアスが回答内容にも強く反映されてしまいます。実際、公式なガイドラインでも「複数の信頼できる情報源で比較検証し、専門機関や第三者の評価も参考にする」ことが推奨されています。

アルゴリズムによる自動判定に頼りすぎず、人間の目で「事実」と「意見」を見極める姿勢が、正しいファクトチェックには不可欠です。

Q:AIで得た情報は、どんな場面で特に有効?

A:AI検索は、速報性や多様な視点が求められる調査や比較分析の場面で、特に威力を発揮します。

AIはリアルタイムで最新データや議論の動向をキャッチし、幅広い情報源から素早くまとめて提示できるからです。

例えば、社会的なトレンドや最新ニュース、複数の統計データの比較など、情報の鮮度や多角的な分析が求められるシーンで活躍しています。

ただし、AIによる調査結果はあくまで「参考情報」とし、最終的な判断や裏付けには必ず人的チェックを組み合わせることが大切です。

Q:成功するファクトチェックのポイントは?

A:AI検索の出典リンクを精読し、複数の信頼ソースで裏付けることが成功のコツです。

独自データや専門家インタビュー、公式発表など、AIだけに頼らず必ず一次情報を調べましょう。AIでまとめた情報は「たたき台」と考え、自分の視点・経験を加えることで独自性と信頼性を両立できます。

- 出典精読&クロスチェック

- 一次情報や実体験も重視

- 人間による最終判断